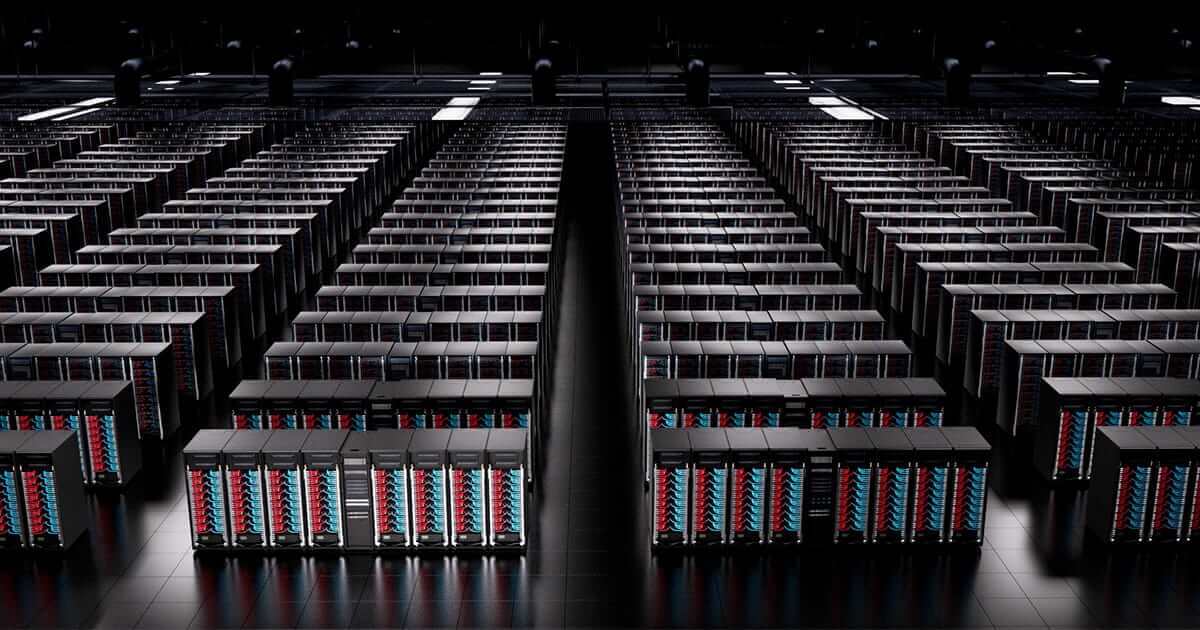

建置超高效能和巨量運算的人工智慧資料中心

技嘉為技術領導者提供強大的頂尖加速基礎設施,這個強大的加速運算平台採用集成八個 NVIDIA HGX™ 或 AMD Instinct™ 加速卡的AI伺服器。GIGAPOD 是一項專業服務,利用極速通訊和相互連接的 NVIDIA NVLink™ 和 AMD Infinity Fabric™ 技術,打造所有機櫃相互連接而形成統一單位的強大GPU運算叢集,實現規模化的平行運算突破AI運算效能。隨著 GIGAPOD 的推出,技嘉為傳統資料中心提供了一站式解決方案,企業能夠執行大規模深度學習模型運算,賦能企業轉型為人工智慧資料中心。技嘉憑藉豐富的硬體、專業知識以及與領先GPU夥伴的密切合作,確保人工智慧超級運算叢集的部署順利進行,並縮減了企業轉型的停滯期。

專業洽詢

環境配置規劃

工程施工

部署

認證與驗收

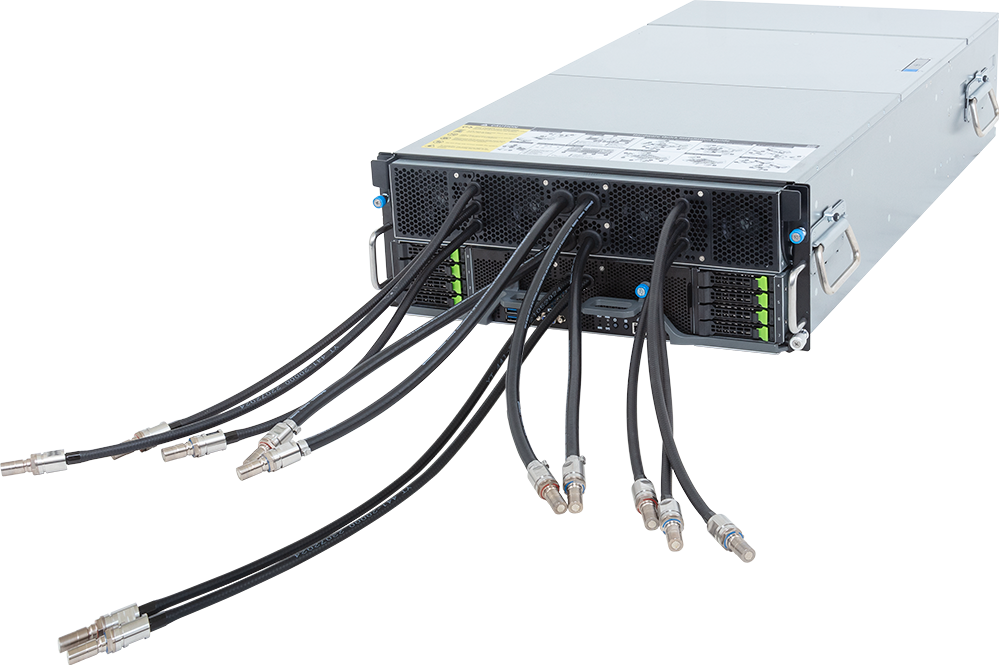

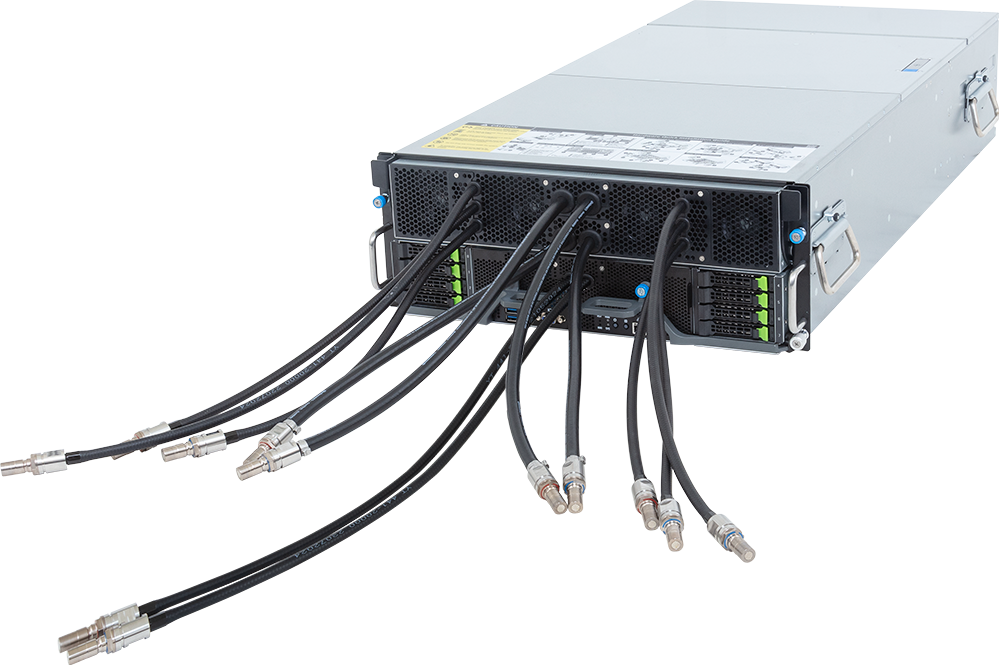

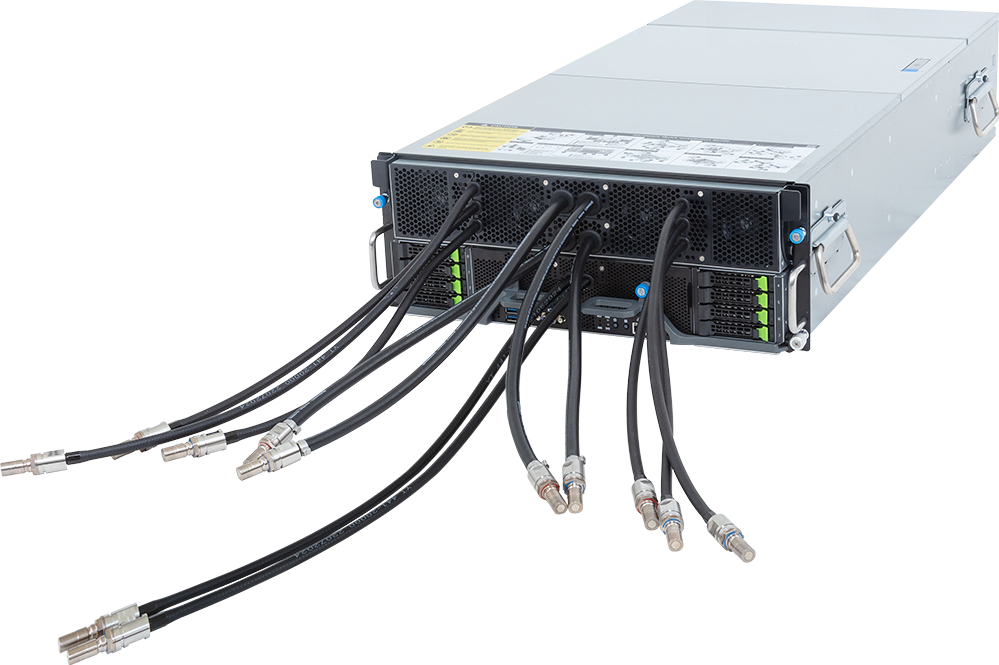

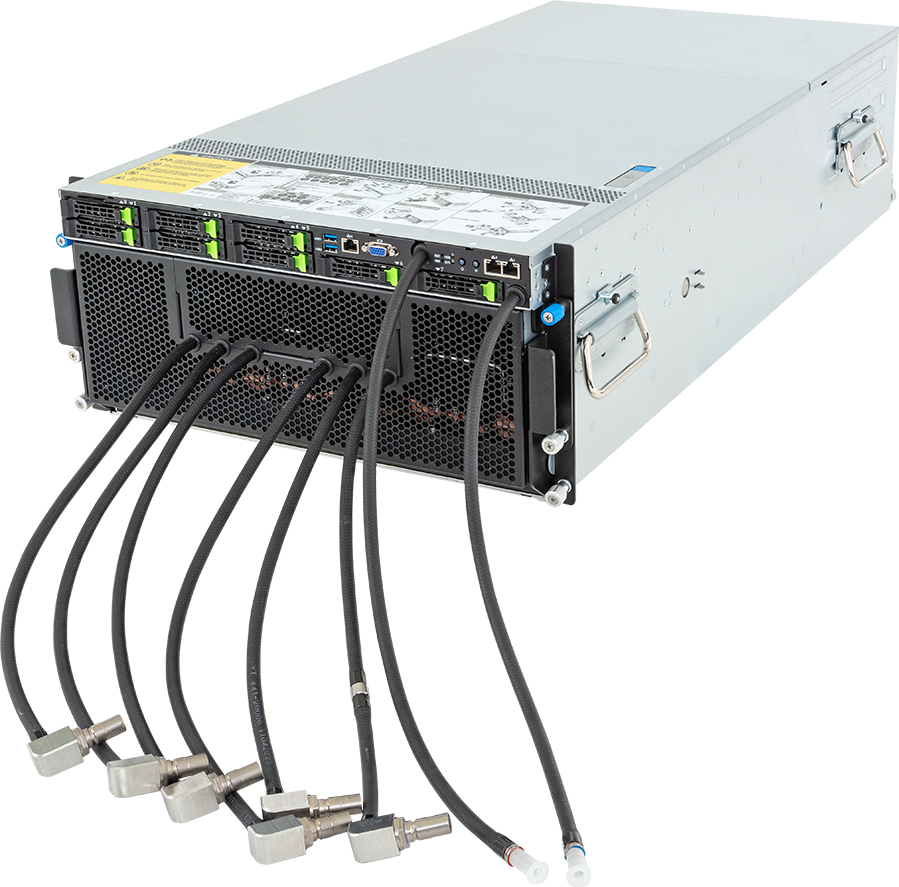

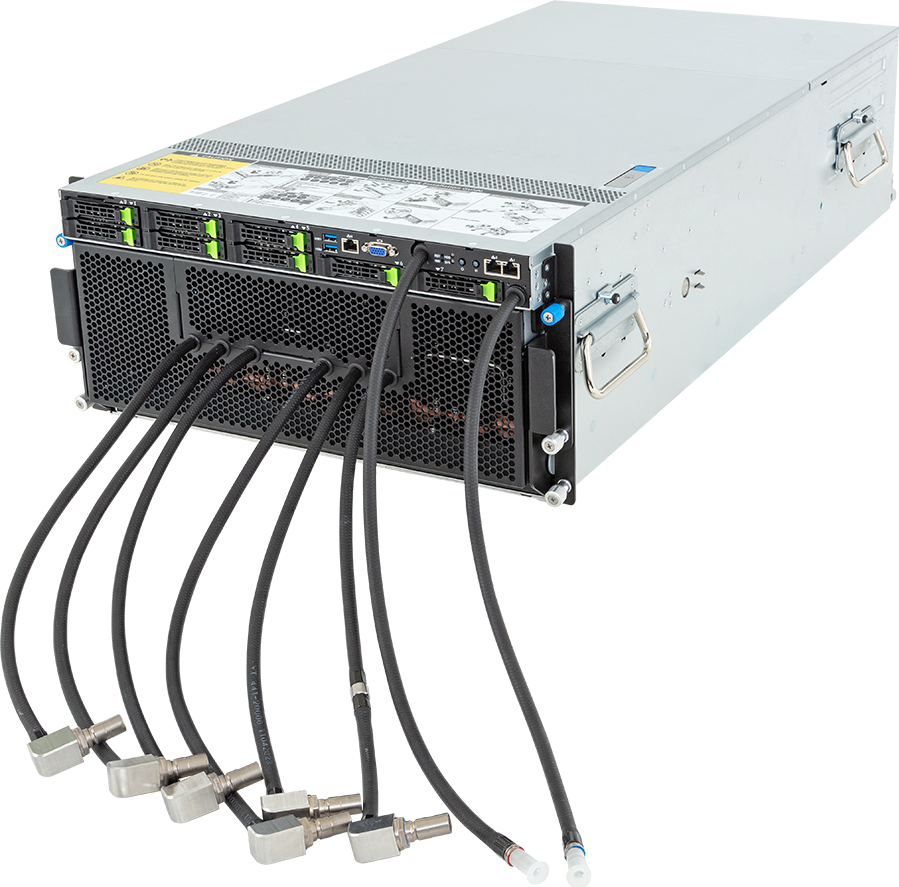

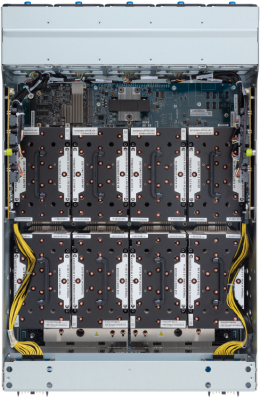

專為八個GPU超級運算平台量身打造的高效能AI伺服器

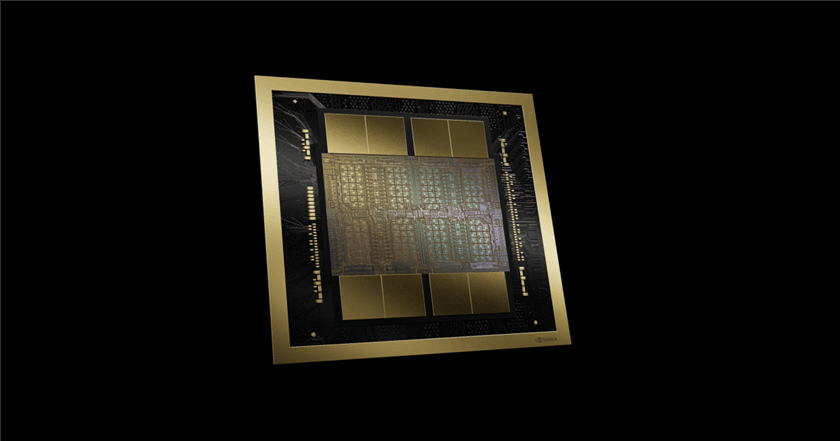

隨著人工智慧的浪潮推進,企業在建置全新AI資料中心時,最迫切的考量是如何選擇合適的硬體設備。技嘉的合作夥伴(包括 AMD、Intel 和 NVIDIA) 皆憑藉其富有遠見和熱誠的研究人員與工程師團隊打造的先進產品。由於每個團隊各有所長,所推出的新一代GPU各自擁有獨特的技術效能提升優勢,使其成為特定客戶和應用的理想選擇。當然,GPU的選擇受到應用領域(AI訓練或推論)、價格、易取得性、系統生態、擴展性和效能等因素的影響。這些決策過程並不容易,但技嘉仍致力於提供客戶多樣化、高度客制化和成熟專業的產品選擇與諮詢服務,協助企業打造理想的資料中心,迎接越來越龐大的人工智慧應用和機器學習模型的需求。

NVIDIA HGX™ B300/B200/H200

最全面的人工智慧軟體生態

最極速GPU通訊互連技術

AMD Instinct™ MI350X/MI325X/MI300X

最龐大且快速的記憶體傳輸

Intel® Gaudi® 3

傑出的AI推論表現

為什麼 GIGAPOD 採用機櫃互聯的運算單元部署?

產業整合力

透過與 AMD、Intel 和 NVIDIA 等技術領導者的密切合作,確保能迅速達成客戶的要求和時間安排。

多樣的產品組合

技嘉擁有豐富多樣的算力產品(GPU 協同運算、獨立運算、儲存和高密度伺服器),可為用戶量身打造,滿足每個客戶的獨特需求。

高度擴展性

一個全方位的高效能資料中心必須確保高度靈活性與未來擴展可能,以便新的系統和新的處理器能夠無痛升級。

高效能運算

從單一 GPU 伺服器到叢集資料中心,技嘉透過最佳化的散熱設計或導入液體冷卻方案以確保提供頂尖運算力。

專業知識與豐富經驗

技嘉已成功部署大型人工智慧資料中心,在客戶需求的時間內提供從諮詢到建置部署的專業服務。

前進超算力人工智慧資料中心的未來

全方位的 GIGAPOD

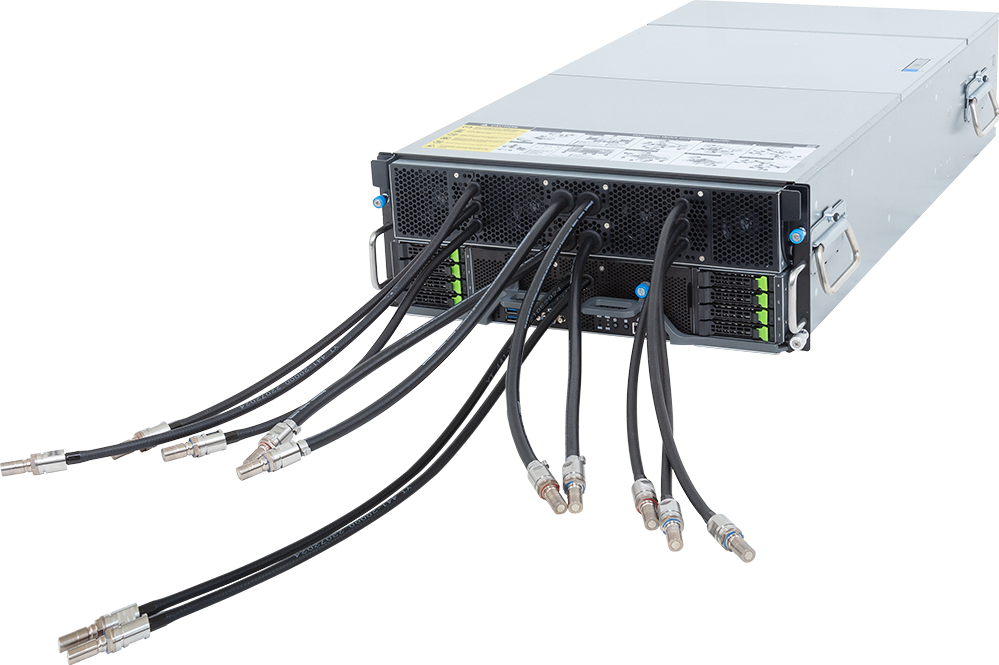

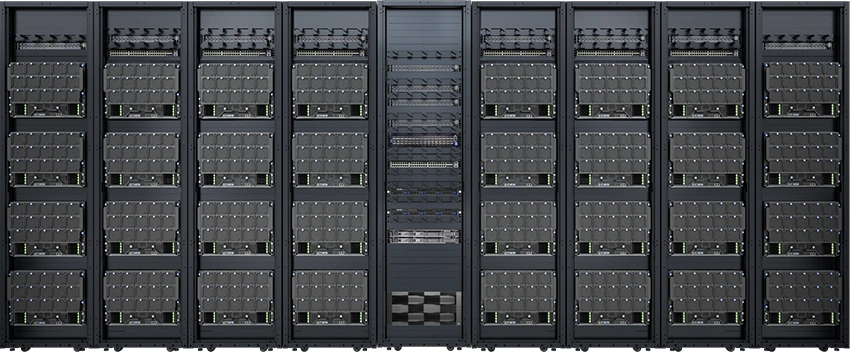

技嘉企業級產品經過嚴格測試,提供相對可靠、實用和輕鬆管理的選擇,包含搭載更多GPU、多種機架規格,以及多元的冷卻散熱方案。身為伺服器領導品牌,我們對於各種IT基礎設施、供應鏈和資料中心的規模都非常熟悉。GIGAPOD 整合式人工智慧解決方案的出現確保了完整的資源整合,協助客戶根據其設施能提供給IT設備的總電量和可用的樓地板面積給予最佳化配置建議。當然,GIGAPOD 提供多種配置方案,從可擴展的零組件到最佳化的散熱設計,從氣冷導入液體冷卻方案,滿足企業各種算力需求。

1 2| Ver. | GPUs Supported | GPU Server (Form Factor) |

GPU Servers per Rack |

Power Consumption per Rack |

No. of Racks per SU* |

|

|---|---|---|---|---|---|---|

| 1 |  |

NVIDIA HGX™ B300/B200/H200 AMD Instinct™ MI350X/MI325X/MI300X |

8U | 4 | 66kW | 8+1 (48U) |

| 2 |  |

NVIDIA HGX™ B200 | 8OU | 4 | 55kW | 8+1 (44OU) |

| 3 |  |

Intel® Gaudi® 3 | 8U | 4 | 62kW | 8+1 (48U) |

| 4 |  |

NVIDIA HGX™ H200 AMD Instinct™ MI300X |

5U | 8 | 100kW | 4+1 (48U) |

| 5 |  |

NVIDIA HGX™ H200 AMD Instinct™ MI300X |

5U | 4 | 50kW | 8+1 (42U) |

| 6 |  |

NVIDIA HGX™ H200 AMD Instinct™ MI300X |

5U | 4 | 50kW | 8+1 (48U) |

*Compute Racks + 1 Management Rack

| Ver. | GPUs Supported | GPU Server (Form Factor) |

GPU Servers per Rack |

Power Consumption per Rack |

No. of Racks per SU* |

CDU | |

|---|---|---|---|---|---|---|---|

| 1 |  |

NVIDIA HGX™ B300/B200/H200 AMD Instinct™ MI355X/MI325X/MI300X |

4U | 8 | 120kW | 4+1 (42U) | In-rack |

| 2 |  |

NVIDIA HGX™ B300/B200/H200 AMD Instinct™ MI355X/MI325X/MI300X |

4U | 8 | 120kW | 4+1 (42U) | In-row |

| 3 |  |

NVIDIA HGX™ B300/B200/H200 AMD Instinct™ MI355X/MI325X/MI300X |

4U | 8 | 120kW | 4+1 (48U) | In-rack |

| 4 |  |

NVIDIA HGX™ B300/B200/H200 AMD Instinct™ MI355X/MI325X/MI300X |

4U | 8 | 120kW | 4+1 (48U) | In-row |

| 5 |  |

NVIDIA HGX™ H200 AMD Instinct™ MI300X |

5U | 8 | 100kW | 4+1 (48U) | In-rack |

| 6 |  |

NVIDIA HGX™ H200 AMD Instinct™ MI300X |

5U | 8 | 100kW | 4+1 (48U) | In-row |

*4 Compute Racks + 1 Management Rack

none

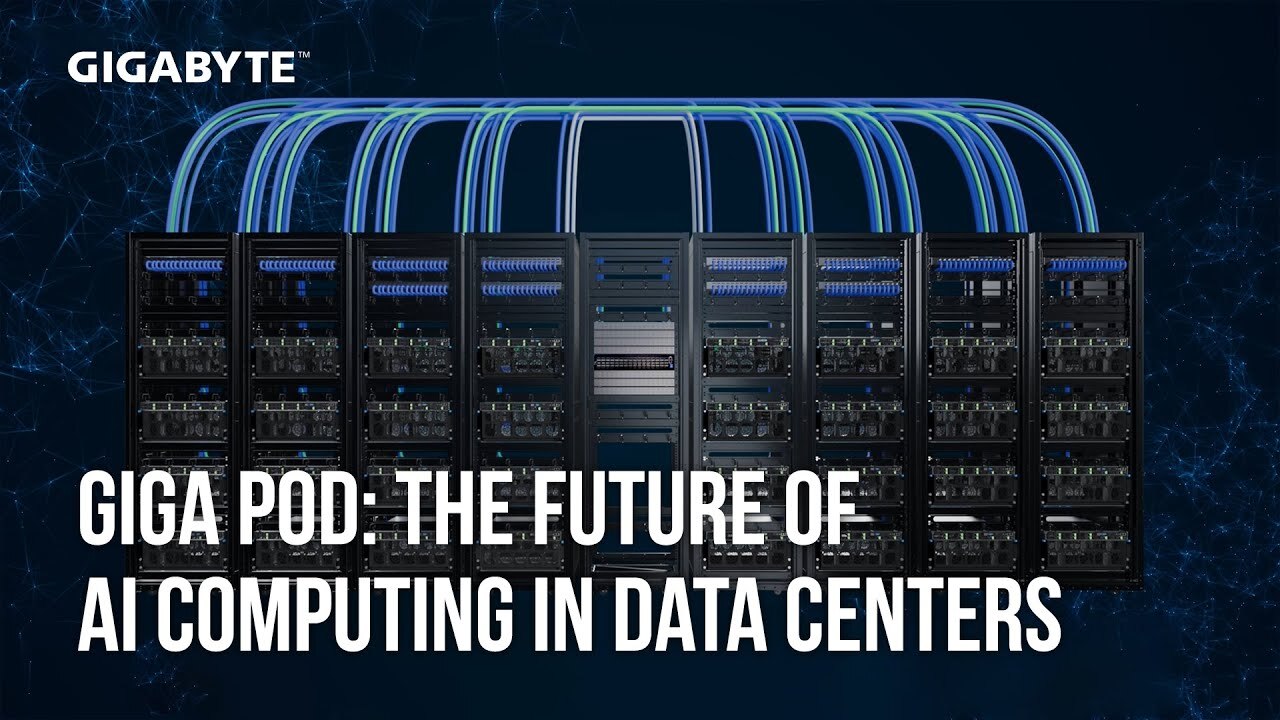

GIGAPOD - 全新的AI運算叢集解決方案

從單一GPU伺服器運算擴展至八個機櫃,每櫃32個GPU,達到總共256個GPU的運算叢集。以GPU伺服器作為核心,技嘉將GIGAPOD穩定的基礎設施規模化,打造出高效能的整合式超算力電腦,進一步成為人工智慧資料中心。

除了GPU伺服器以AI機櫃的組合亮相,GIGAPOD 在每八個GPU機櫃組合中配置一個網路交換器機櫃,實現了算力水平的 LEVEL UP 與 SCALE OUT,確保在嚴苛的平行運算環境中,GPU能夠以最高速度進行傳輸,進而擴大產品影響力。技嘉提供全方位的專用硬體、相容性軟體支援以及專業諮詢服務,讓資料中心的部署更加輕鬆無負擔。

GIGABYTE POD Manager (GPM)

GIGAPOD 整合技嘉自主開發的人工智慧資料中心基礎設施管理平台 GIGABYTE POD Manager (GPM),可即時監控、智慧調度及自動化運算流程,顯著簡化 AI 與 HPC 營運。從硬體部署到叢集管理,GIGAPOD 提供全面的專業知識與技術支援,協助大型 AI 資料中心高效整合基礎設施,快速應對各類 AI 挑戰,並加速應用落地。

GPU運算叢集的應用領域

技嘉AI伺服器

一條龍服務打造未來的AI資料中心

這個整合性的資料中心生態系統提供了必要的專業知識、資源、創新和互操作性,來構建、部署和維護頂尖的大規模AI資料中心。技嘉持續擴展其在各自領域內的領導合作夥伴,確保資料中心規模的專案在任何階段不會因故停滯。透過已發展和持續加入的合作夥伴生態系統,企業將迅速獲得其投資的成果。

1

2

3

4

5

6